07

مهآموزش پردازش متن Text processing

- نویسنده : nivad

- ارسال شده در: 15 فوریه 2025

- ارسال دیدگاه: 0

آموزش پردازش متن Text processing

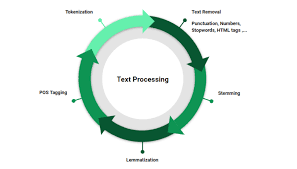

پردازش متن، یا “Text Processing“، به مجموعهای از تکنیکها و روشها برای تحلیل و پردازش متون نوشتاری اشاره دارد. این فرآیند معمولاً شامل مجموعهای از مراحل میشود که به شرح زیر است:

پیشپردازش متن (Text Preprocessing): شامل کارهایی مانند حذف نویز، حذف علائم نگارشی، حذف کلمات توقف (Stop Words) و تبدیل متن به حروف کوچک.

واژهسازی (Tokenization): شکستن متن به واحدهای کوچکتر مانند کلمات یا جملات.

ریشهیابی (Stemming) و لماتیزاسیون (Lemmatization): فرآیندهای کاهش کلمات به شکل پایهایترشان.

نمایش متن (Text Representation): تبدیل متن به فرمتهای عددی مانند بگ آو ووردز (Bag of Words) یا TF-IDF، که برای الگوریتمهای یادگیری ماشین مناسب باشد.

استخراج ویژگیها (Feature Extraction): شناسایی و استخراج ویژگیهای مهم از متن.

مدلسازی (Modeling): استفاده از الگوریتمهای یادگیری ماشین و مدلهای آماری برای تحلیل و پیشبینی.

ارزیابی مدل (Model Evaluation): سنجش عملکرد مدل با استفاده از معیارهایی مانند دقت، یادآوری و F1-Score.

پیشپردازش متن (Text Preprocessing)

پیشپردازش متن یکی از مهمترین مراحل در پردازش متن است و شامل چندین گام است که متن را برای تحلیل و استفاده در مدلهای یادگیری ماشین آماده میکند. در زیر برخی از گامهای مهم پیشپردازش متن آمده است:

حذف نویز: حذف نویزها شامل حذف اعداد، علائم نگارشی و کاراکترهای غیرضروری از متن است.

حذف کلمات توقف (Stop Words): کلمات توقف مانند “و”، “به”، “از” که معمولاً در تحلیل متن اهمیت ندارند، حذف میشوند تا متن تمیزتر شود.

تبدیل حروف کوچک (Lowercasing): تبدیل تمامی حروف به حروف کوچک به منظور یکسانسازی متن.

توکنسازی (Tokenization): شکستن متن به واحدهای کوچکتر مانند کلمات یا جملات. این کار به مدلها امکان تحلیل دقیقتر را میدهد.

ریشهیابی (Stemming): تبدیل کلمات به ریشههایشان (مثلاً تبدیل “کتابها” به “کتاب”)، که میتواند به کاهش پیچیدگی کمک کند.

لماتیزاسیون (Lemmatization): شبیه به ریشهیابی، اما با در نظر گرفتن فرمهای دستور زبانی کلمات، به طوری که کلمات به شکل پایهایشان برگردانده میشوند (مثلاً تبدیل “رفتند” به “رفت”).

برداشتن فاصلههای اضافی: حذف فاصلههای اضافی و چندگانه که ممکن است در متن وجود داشته باشد.

تبدیل به بردارها (Vectorization): تبدیل متن به بردارهای عددی که میتواند شامل روشهایی مانند بگ آو ووردز (Bag of Words) یا TF-IDF باشد.

واژهسازی (Tokenization)

واژهسازی یا Tokenization فرآیندی است که در آن متن به واحدهای کوچکتر مثل کلمات، جملات یا عبارات تقسیم میشود. این کار به مدلها و الگوریتمهای یادگیری ماشین امکان تحلیل و پردازش دقیقتر متن را میدهد. در زیر چند روش رایج برای واژهسازی آمده است:

واژهسازی بر اساس فاصله (Whitespace Tokenization): یکی از سادهترین روشها که در آن متن بر اساس فاصلهها (Space) تقسیم میشود. این روش برای زبانهایی که کلمات با فاصله از هم جدا میشوند، مناسب است.

واژهسازی بر اساس علائم نگارشی (Punctuation Tokenization): در این روش، متن بر اساس علائم نگارشی مانند نقطه، ویرگول، علامت تعجب و علامت سوال تقسیم میشود. این روش کمک میکند تا جملات و عبارات جداگانه شناسایی شوند.

واژهسازی با استفاده از کتابخانههای موجود (Library-based Tokenization): استفاده از کتابخانهها و ابزارهای موجود مانند NLTK (Natural Language Toolkit)، SpaCy یا Stanford NLP که توابع پیشرفتهتری برای واژهسازی ارائه میدهند.

واژهسازی مبتنی بر الگو (Pattern-based Tokenization): استفاده از الگوهای خاص مانند عبارات باقاعده (Regular Expressions) برای شناسایی و جداسازی واحدهای متنی مورد نظر.

برای مثال در کتابخانه Python، کد زیر نشان میدهد چگونه میتوان با استفاده از NLTK یک متن را واژهسازی کرد:

import nltk

nltk.download('punkt')

from nltk.tokenize import word_tokenize

text = "پردازش زبان طبیعی یک زمینه جذاب از علم کامپیوتر است."

tokens = word_tokenize(text, language='persian')

print(tokens)ریشهیابی (Stemming) و لماتیزاسیون (Lemmatization)

ریشهیابی (Stemming) و لماتیزاسیون (Lemmatization) دو روش مهم در پیشپردازش متن هستند که هر دو به کاهش کلمات به شکل پایهایترشان کمک میکنند، اما با رویکردهای مختلف. در ادامه این دو روش را توضیح میدهم:

ریشهیابی (Stemming)

ریشهیابی فرآیندی است که در آن کلمات به ریشه یا بخش پایهایشان کاهش مییابند. این کار معمولاً با استفاده از الگوریتمهایی انجام میشود که حروف پایانی یا بخشهای اضافی کلمات را حذف میکنند. مثلاً:

“کتابها” به “کتاب”

“خواندن” به “خوان”

ریشهیابی معمولاً سادهتر و سریعتر است، اما ممکن است دقت کمتری داشته باشد و گاهی منجر به تولید کلمات غیرقابل قبول شود.

لماتیزاسیون (Lemmatization)

لماتیزاسیون فرآیندی پیچیدهتر است که در آن کلمات به شکل اصلی و پایهای خود برگردانده میشوند، با در نظر گرفتن فرمهای دستور زبانی و معنایی. این روش از دیکشنریهای لغوی و قواعد گرامری برای شناسایی شکل اصلی کلمه استفاده میکند. مثلاً:

“رفتند” به “رفت”

“بهترین” به “بهتر”

لماتیزاسیون دقت بالاتری دارد و کلمات را به شکل صحیحتری برمیگرداند، اما ممکن است به منابع محاسباتی بیشتری نیاز داشته باشد.

مثال کد در Python:

در ادامه یک مثال ساده از هر دو روش با استفاده از کتابخانه NLTK در Python آوردهام:

ریشهیابی با استفاده از NLTK:

from nltk.stem import PorterStemmer

porter = PorterStemmer()

words = ["books", "reading", "readability"]

stems = [porter.stem(word) for word in words]

print(stems) # خروجی: ['book', 'read', 'readabl']

لماتیزاسیون با استفاده از NLTK:

from nltk.stem import WordNetLemmatizer

nltk.download('wordnet')

nltk.download('omw-1.4')

lemmatizer = WordNetLemmatizer()

words = ["better", "running", "ran"]

lemmas = [lemmatizer.lemmatize(word) for word in words]

print(lemmas) # خروجی: ['better', 'running', 'ran']نمایش متن (Text Representation)

نمایش متن (Text Representation) یکی از گامهای مهم در پردازش متن است که در آن متن به فرمتی تبدیل میشود که مدلهای یادگیری ماشین بتوانند با آن کار کنند. چندین روش برای نمایش متن وجود دارد که به برخی از رایجترین آنها اشاره میکنم:

۱. بگ آو ووردز (Bag of Words)

در این روش، هر کلمه به یک ویژگی تبدیل میشود و تعداد تکرار هر کلمه در متن شمارش میشود. این روش ساده است و برای برخی از کاربردها مفید است، اما روابط بین کلمات را در نظر نمیگیرد.

۲. TF-IDF (Term Frequency-Inverse Document Frequency)

این روش تعداد تکرار هر کلمه (TF) و میزان اهمیت کلمه در کل مجموعه متون (IDF) را با هم ترکیب میکند. کلمات پرکاربرد در تمامی متون اهمیت کمتری نسبت به کلمات خاصتر دارند.

۳. ورد امبدینگ (Word Embedding)

ورد امبدینگها نمایشهای برداری کلمات هستند که روابط معنایی بین کلمات را در نظر میگیرند. برخی از مدلهای ورد امبدینگ عبارتند از:

Word2Vec: مدل معروفی که کلمات را به بردارهای کمبعدی تبدیل میکند.

GloVe (Global Vectors for Word Representation): مدل دیگری که با استفاده از ماتریسهای هموقوعی کلمات، بردارهای کلمات را محاسبه میکند.

۴. نمایشهای مبتنی بر جملات (Sentence Embeddings)

این روشها جملات را به بردارهایی تبدیل میکنند که روابط معنایی بین جملات را نیز در نظر میگیرند. برخی از مدلهای معروف عبارتند از:

BERT (Bidirectional Encoder Representations from Transformers): مدل پیچیدهتری که توانایی درک معنای جملات و کلمات در متون طولانیتر را دارد.

Universal Sentence Encoder (USE): مدل دیگری که جملات را به بردارهای کمبعدی تبدیل میکند و برای کاربردهای مختلف مناسب است.

مثال کد در Python:

در ادامه یک مثال ساده از استفاده از TF-IDF با استفاده از کتابخانه Scikit-learn در Python آمده است:

from sklearn.feature_extraction.text import TfidfVectorizer

texts = [

"پردازش زبان طبیعی یک زمینه جذاب است",

"ما در حال یادگیری پردازش متن هستیم"

]

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(texts)

print(vectorizer.get_feature_names_out())

print(X.toarray())استخراج ویژگیها (Feature Extraction)

استخراج ویژگیها یکی از مراحل حیاتی در پردازش متن است که شامل شناسایی و استخراج اطلاعات مهم و مفید از متنها میباشد. این ویژگیها میتوانند به مدلهای یادگیری ماشین کمک کنند تا بهتر متنها را تحلیل و پیشبینی کنند. در ادامه چند روش رایج برای استخراج ویژگیها آمده است:

1. کیسه کلمات (Bag of Words)

این روش شامل شمارش تعداد تکرار هر کلمه در متن میباشد. هر کلمه به عنوان یک ویژگی در نظر گرفته میشود و تعداد تکرار آن به عنوان مقدار آن ویژگی.

2. فرکانس اصطلاح-معکوس فراوانی سند (TF-IDF)

این روش ترکیبی از فرکانس هر کلمه در یک متن (TF) و میزان نادر بودن آن کلمه در کل مجموعه متون (IDF) را استفاده میکند تا به هر کلمه وزنی بدهد. این روش میتواند کلمات کم اهمیت را فیلتر کند و بر کلمات خاصتر تمرکز کند.

3. ورد امبدینگ (Word Embeddings)

ورد امبدینگها بردارهای عددی کمبعدی هستند که روابط معنایی بین کلمات را حفظ میکنند. مدلهای مشهور شامل Word2Vec، GloVe و FastText هستند.

4. نمایش مبتنی بر جملات (Sentence Embeddings)

این روشها جملات را به بردارهای عددی تبدیل میکنند که میتوانند روابط معنایی بین جملات را نیز در نظر بگیرند. مدلهایی مانند BERT و Universal Sentence Encoder از این روشها استفاده میکنند.

5. استخراج ویژگیهای تخصصی

برای کاربردهای خاص، ویژگیهای دیگری مانند نامهای موجود در متن (Named Entity Recognition)، بخشهای گفتاری (Part-of-Speech Tagging) و وابستگیهای دستوری (Dependency Parsing) نیز میتوانند مفید باشند.

مثال کد در Python:

در ادامه یک مثال ساده از استفاده از TF-IDF با استفاده از کتابخانه Scikit-learn در Python آوردهام:

from sklearn.feature_extraction.text import TfidfVectorizer

texts = [

"پردازش زبان طبیعی یک زمینه جذاب است",

"ما در حال یادگیری پردازش متن هستیم"

]

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(texts)

print(vectorizer.get_feature_names_out())

print(X.toarray())

مدلسازی (Modeling)

مدلسازی یا Modeling در پردازش متن شامل استفاده از الگوریتمهای یادگیری ماشین و مدلهای آماری برای تحلیل، پیشبینی و استخراج اطلاعات از متنها است. در ادامه چند روش و الگوریتم رایج برای مدلسازی متن را معرفی میکنم:

۱. مدلهای کلاسیک

Naive Bayes: یک مدل احتمالاتی ساده که برای طبقهبندی متنها استفاده میشود.

Logistic Regression: یک مدل رگرسیونی برای طبقهبندی دودویی و چندگانه.

Support Vector Machines (SVM): یک الگوریتم قدرتمند برای طبقهبندی که از بردارهای پشتیبان استفاده میکند.

۲. مدلهای مبتنی بر درخت تصمیم

Decision Trees: ساختارهای درختی که برای طبقهبندی و رگرسیون استفاده میشوند.

Random Forest: مجموعهای از درختهای تصمیم که برای بهبود دقت و کاهش اورفیتینگ استفاده میشود.

Gradient Boosting: روشی که درختهای تصمیم را به صورت پیوسته و با بهبود خطاها آموزش میدهد.

۳. مدلهای مبتنی بر ورد امبدینگ و شبکههای عصبی

Word2Vec: مدل معروفی که کلمات را به بردارهای کمبعدی تبدیل میکند.

GloVe (Global Vectors for Word Representation): مدل دیگری که با استفاده از ماتریسهای هموقوعی کلمات، بردارهای کلمات را محاسبه میکند.

Recurrent Neural Networks (RNN): شبکههای عصبی بازگشتی که توانایی تحلیل توالیها را دارند.

Long Short-Term Memory (LSTM): یک نوع RNN که میتواند وابستگیهای بلندمدت را حفظ کند.

Bidirectional Encoder Representations from Transformers (BERT): مدل پیچیدهتری که توانایی درک معنای جملات و کلمات در متون طولانیتر را دارد.

۴. مدلهای جدید و مبتنی بر ترنسفورمرها

GPT-3: مدل بزرگی که توسط OpenAI توسعه داده شده و میتواند برای تولید و تکمیل متنها، ترجمه و سایر وظایف استفاده شود.

T5 (Text-to-Text Transfer Transformer): مدل قدرتمندی که تمام وظایف پردازش زبان را به فرم متن به متن تبدیل میکند.

مثال کد در Python با استفاده از مدلهای کلاسیک:

در ادامه یک مثال ساده از استفاده از Naive Bayes برای طبقهبندی متون با استفاده از کتابخانه Scikit-learn در Python آوردهام:

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

texts = [

"این یک پیام مثبت است",

"این یک پیام منفی است",

"پیام خوب و مثبت دیگری"

]

labels = [1, 0, 1] # 1 = مثبت، 0 = منفی

model = make_pipeline(TfidfVectorizer(), MultinomialNB())

model.fit(texts, labels)

predicted = model.predict(["این پیام عالی است"])

print(predicted) # خروجی: [1] (مثبت)

این کد یک مدل ساده Naive Bayes را ایجاد میکند که متون ورودی را به بردارهای TF-IDF تبدیل کرده و سپس آنها را طبقهبندی میکند.

ارزیابی مدل (Model Evaluation)

ارزیابی مدل (Model Evaluation) مرحلهای حیاتی در فرآیند مدلسازی است که به ما کمک میکند تا عملکرد مدل را بسنجیم و از دقت و کارایی آن اطمینان حاصل کنیم. در ادامه به برخی از روشها و معیارهای ارزیابی مدلها اشاره میکنم:

۱. تقسیم دادهها (Train/Test Split)

یکی از روشهای رایج، تقسیم دادهها به دو مجموعه آموزش (Training) و آزمون (Testing) است. مدل با استفاده از دادههای آموزش آموزش داده میشود و سپس با دادههای آزمون ارزیابی میشود.

۲. اعتبارسنجی متقاطع (Cross-Validation)

این روش شامل تقسیم دادهها به چند مجموعه تقسیم (Folds) و انجام فرآیند آموزش و ارزیابی به صورت چندباره است. اعتبارسنجی متقاطع کمک میکند تا ارزیابی مدل به شکلی دقیقتر و پایدارتر انجام شود.

۳. معیارهای ارزیابی (Evaluation Metrics)

چندین معیار مختلف برای ارزیابی مدلها وجود دارد. برخی از رایجترین آنها عبارتند از:

دقت (Accuracy): درصد نمونههای درست طبقهبندی شده به کل نمونهها.

دقت پیشبینی مثبت (Precision): درصد نمونههای درست پیشبینی شده به کل نمونههای پیشبینی شده به عنوان مثبت.

بازخوانی (Recall): درصد نمونههای درست پیشبینی شده به کل نمونههای واقعی مثبت.

F1-Score: میانگین هموزن دقت پیشبینی مثبت و بازخوانی.

ماتریس سردرگمی (Confusion Matrix): جدولی که تعداد پیشبینیهای درست و غلط را برای هر کلاس نشان میدهد.

مثال کد در Python:

در ادامه یک مثال ساده از استفاده از معیارهای ارزیابی با استفاده از کتابخانه Scikit-learn در Python آوردهام:

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, confusion_matrix

from sklearn.naive_bayes import MultinomialNB

from sklearn.feature_extraction.text import TfidfVectorizer

texts = [

"این یک پیام مثبت است",

"این یک پیام منفی است",

"پیام خوب و مثبت دیگری"

]

labels = [1, 0, 1] # 1 = مثبت، 0 = منفی

# تقسیم دادهها به آموزش و آزمون

X_train, X_test, y_train, y_test = train_test_split(texts, labels, test_size=0.3, random_state=42)

# ساخت و آموزش مدل

vectorizer = TfidfVectorizer()

X_train_vec = vectorizer.fit_transform(X_train)

model = MultinomialNB()

model.fit(X_train_vec, y_train)

# پیشبینی و ارزیابی مدل

X_test_vec = vectorizer.transform(X_test)

y_pred = model.predict(X_test_vec)

print("Accuracy:", accuracy_score(y_test, y_pred))

print("Precision:", precision_score(y_test, y_pred))

print("Recall:", recall_score(y_test, y_pred))

print("F1-Score:", f1_score(y_test, y_pred))

print("Confusion Matrix:\n", confusion_matrix(y_test, y_pred))

این کد مدل را آموزش میدهد و معیارهای ارزیابی مختلفی مانند دقت، دقت پیشبینی مثبت، بازخوانی، F1-Score و ماتریس سردرگمی را برای مدل محاسبه میکند.

جستجو

دسته بندی ها

- آخرین آموزش ها (3)

- پراجکت سرور (18)

- شیرپوینت (70)

- طراحی سایت (37)

- فناوری اطلاعات (343)

- مایکروسافت داینامیک (8)

پست های محبوب

درباره شرکت

در خبرنامه ما مشترک شوید و آخرین اخبار و به روزرسانی های را در صندوق ورودی خود مستقیماً دریافت کنید.

آخرین دیدگاهها

- محمد در ERP ابری | راهنمای 100% پیادهسازی برای کسبوکارها

- نرمافزارهای ERP ابری و نقش SharePoint در یکپارچهسازی سازمانی - اطلس وب در ERP ابری | راهنمای 100% پیادهسازی برای کسبوکارها

- Mahmood در مدیریت ریسک و تغییرات پراجکت سرور

- Bashir در محدودیت های پراجکت سرور

- خاوری در معرفی پراجکت سرور

دیدگاه بگذارید